Share This Article

RESUME EXECUTIF

En droit français, l’absence d’accès frauduleux aux systèmes exclut l’application de l’article 323-1 du Code pénal. Néanmoins, l’entreprise déployant l’IA pourrait être poursuivie pour complicité de contenu illicite généré si elle n’a pas mis en place de garde-fous.

L’AI Act européen (Réglement UE 2024/1689 du Parlement européen et du Conseil du 13 juin 2024, Journal officiel UE, 12 juillet 2024, entré en vigueur le 1er août 2024, ) s’applique principalement aux systèmes considérés comme « à haut risque », laissant les agents IA d’entreprise classiques moins encadrés quant aux obligations de supervision.

Le RGPD offre un recours indirect. L’absence de mécanismes de sécurité sémantiques constitue une faute au titre de l’obligation de sécurité des traitements, si des données personnelles sont exposées lors d’un acte malveillant (ex: phishing).

Le principal champ de bataille reste la responsabilité civile.

L’absence de « guardrails » sémantiques sera qualifiée de faute caractérisée (Art. 1240 CC), engageant la responsabilité de l’entreprise pour les dommages subis par les victimes (préjudices financiers, atteinte à la réputation).

La responsabilité du fait des choses (Art. 1242 CC) reste théorique, l’IA étant majoritairement vue comme immatérielle, tandis que le régime du produit défectueux dépendra de la classification de l’IA selon l’AI Act (en cours d’harmonisation via directive UE 2024/2853).

Pour atténuer ce risque, des recommandations opérationnelles urgentes sont formulées :

– la mise en place de pare-feux sémantiques (Lakera Guard, etc.),

– l’implémentation systématique du « Human-in-the-Loop » sur les tâches critiques,

– la conservation de logs complets,

– la nomination d’un responsable conformité IA, et

– la réalisation d’audits de « Red Teaming » sémantique.

Ainsi, la responsabilité des entreprises ne résidera pas dans le fait d’avoir été victime, mais dans l’absence de diligence raisonnable.

Les tribunaux appliqueront le droit commun de la responsabilité.

Déployer une IA sans boucles de contrôle est désormais une faute juridique caractérisée, et la conformité aux futures exigences de l’AI Act servira de preuve de diligence.

I. LE RÈGLEMENT EUROPÉEN SUR L’INTELLIGENCE ARTIFICIELLE (AI ACT)

L’AI Act européen, le Règlement (UE) 2024/1689, dont l’entrée en vigueur est fixée au 1er août 2024, avec application progressive débutant le 2 février 2025 pour les pratiques interdites (Art. 6-7, Annexe III) classe les systèmes d’IA selon leur niveau de risque avec des obligations distinctes.

1. Les systèmes interdits incluent la manipulation cognitive préjudiciable et l’identification biométrique en temps réel (hors exceptions).

2. Les systèmes à haut risque (définis par leur usage dans des domaines critiques comme les infrastructures, l’emploi, ou la justice) sont soumis à des exigences strictes dès le 2 août 2026 (exceptions jusqu’en 2027), portant sur la gestion des risques, la qualité des données, la documentation technique, la traçabilité (logs), la transparence et la surveillance humaine.

3. Un chatbot RH automatisant le recrutement est cité comme exemple de système à haut risque.

4. Les Modèles d’IA à usage général (GPAI) comme GPT-4 sont concernés à partir du 2 août 2025.

Leurs fournisseurs doivent fournir une documentation technique détaillée, respecter le droit d’auteur via leurs données d’entraînement et assurer une politique de performance énergétique.

Les GPAI présentant un risque systémique sont soumis à des évaluations adversariales et à un reporting d’incidents.

L’impact diffère selon l’usage des entreprises : utilisation via API ou développement propriétaire.

5. Certains systèmes nécessitent une transparence obligatoire, notamment les deepfakes et les chatbots, qui doivent clairement divulguer leur nature artificielle à l’utilisateur final.

6. Les systèmes à risque minimal (ex: filtre anti-spam) n’ont pas d’obligations spécifiques. Concernant le « prompt injection », l’Article 15 de l’AI Act impose aux systèmes à haut risque de garantir leur robustesse et cybersécurité face aux tentatives de tiers exploitant des vulnérabilités.

Disposition pertinente : Article 15 (robustesse et cybersécurité)

« Les systèmes d’IA à haut risque sont conçus et développés de manière à être résilients en ce qui concerne les erreurs, les défaillances ou les incohérences pouvant survenir dans le système ou l’environnement dans lequel le système fonctionne […] y compris contre les tentatives de tiers de modifier leur utilisation ou leurs performances en exploitant les vulnérabilités du système. »

Le prompt injection est interprété comme une telle exploitation. Les systèmes doivent intégrer des protections conformes à l’état de l’art.

Le non-respect de cette obligation pour les systèmes à haut risque expose à des sanctions financières importantes (jusqu’à 35 M€ ou 7% du CA mondial).

VÉRIFICATION DES FONDEMENTS LÉGAUX

A. Droit pénal français. Article 323-1 du Code pénal

1. Texte applicable

Article 323-1 du Code pénal (modifié par LOI n°2023-22 du 24 janvier 2023) :

« Le fait d’accéder ou de se maintenir, frauduleusement, dans tout ou partie d’un système de traitement automatisé de données est puni de trois ans d’emprisonnement et de 100 000 € d’amende.«

2. Inapplicabilité au vibe-hacking

L’article 323-1 exige un accès frauduleux à un système, ce qui implique (a) une pénétration irrégulière dans un système protégé, (b) le contournement de dispositifs de sécurité, (c) un franchissement de barrières techniques.

Jurisprudence établie :

CA Paris, 5 avril 1994 : « L’accès frauduleux vise tous les modes de pénétration irréguliers d’un système ».

CA Paris, 30 octobre 2002 : pas d’infraction si accès via simple navigateur sans forcer les protections.

Cass. crim., 2 septembre 2025 (n° 24-83.605) : même avec droits d’accès, le maintien hors finalité autorisée constitue une fraude.

Application au prompt injection. Le « vibe-hacking » consiste à manipuler linguistiquement une IA en utilisant ses fonctionnalités normales.

Il n’y a (a) pas de contournement technique de protections, (b) pas d’accès à un système normalement interdit, (c) pas d’utilisation d’outils spécialisés (au sens de l’art. 323-3-1).

Conclusion. L’article 323-1 ne s’applique pas au prompt injection car celui-ci exploite le fonctionnement normal de l’IA, non un accès frauduleux.

3. Articles connexes potentiellement applicables

Article 323-3 du Code pénal (modification frauduleuse de données) pourrait s’appliquer si le prompt injection entraîne l’introduction, extraction ou modification frauduleuse de données.

Exemples : exfiltration de bases de données clients, corruption de RAG (Retrieval-Augmented Generation).

Conditions cumulatives : (a) accès légitime initial (donc pas de 323-1), (b) intention frauduleuse caractérisée (élément moral), (c) résultat dommageable sur les données.

B. Règlement général sur la protection des données (RGPD)

1. Article 32 RGPD : obligation de sécurité des traitements

Texte (Règlement UE 2016/679, art. 32) :

« Le responsable du traitement et le sous-traitant mettent en œuvre les mesures techniques et organisationnelles appropriées afin de garantir un niveau de sécurité adapté au risque. »

Mesures exigées : (a) pseudonymisation et chiffrement, (b) garantie de confidentialité, intégrité, disponibilité et résilience, (c) procédure de test et d’évaluation régulière, (d) mesures organisationnelles (formation, instructions, traçabilité).

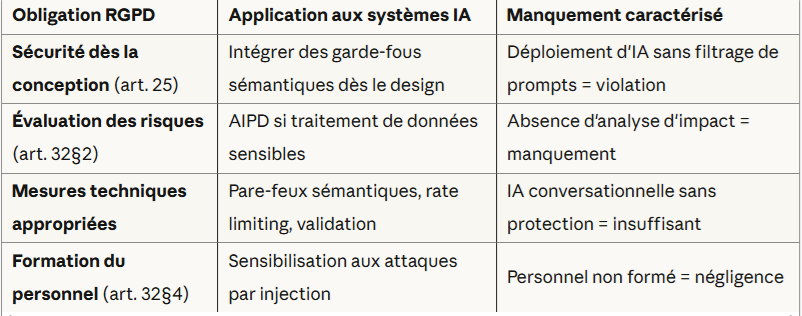

Application au prompt injection : (a) obligation RGPD, (b) application aux systèmes IA, (c) manquement caractérisé.

Sécurité dès la conception (art. 25)

Intégrer des garde-fous sémantiques dès le design et déploiement d’IA sans filtrage de prompts est considéré comme une violation.

Évaluation des risques (art. 32 §2)

AIPD si traitement de données sensibles et absence d’analyse d’impact est considéré comme un manquement.

Mesures techniques appropriées

(a) Pare-feux sémantiques, rate limiting, validation et (b) IA conversationnelle sans protection sont considérés comme insuffisants.

Formation du personnel (art. 32§4)

Sensibilisation aux attaques par injection et le personnel non formé et considéré comme une négligence.

Sanctions CNIL récentes :

Dedalus Biologie (2022) : 1,5M€ d’amende pour fuite de 500 000 dossiers médicaux due à défauts de sécurité.

Critère d’évaluation : État de l’art en cybersécurité IA

2. Qualification juridique du manquement

L’absence de mécanismes de sécurité sémantiques constitue une violation de l’article 32 RGPD si (a) le système d’IA traite des données personnelles, (b) une attaque par prompt injection expose ces données, (c) l’entreprise n’a pas mis en œuvre de mesures appropriées.

Conséquence : la responsabilité administrative (sanctions CNIL) et civile (dommages-intérêts aux victimes).

Références

Autorités françaises :

- CNIL (Protection des données) : +33 1 53 73 22 22 | cnil.fr

- ANSSI (Cybersécurité) : +33 1 71 75 84 00 | cyber.gouv.fr

- ANSM (Santé – dispositifs médicaux) : +33 1 55 87 30 00 | ansm.sante.fr

Organisations professionnelles :

- Impact AI (ex-Hub France IA) : impact-ai.fr

- AFCDP (Data Protection Officers) : afcdp.net

- CIGREF (DSI grandes entreprises) : cigref.fr

Prestataires sécurité IA :

- Lakera (Guardrails commerciaux) : lakera.ai

- HiddenLayer (Sécurité ML/AI) : hiddenlayer.com

- Robust Intelligence (Testing & Monitoring) : robustintelligence.com

Ce document constitue une analyse juridique préliminaire et ne saurait se substituer à un conseil juridique personnalisé. Les informations contenues sont à jour au 19 novembre 2025 et susceptibles d’évolution.